NEWS

-

スマートフォン・PC向けシネマティック錬金術RPG『レスレリアーナのアトリエ〜忘れられた錬金術と極夜の解放者〜』、英語・繁体字中国語・簡体字中国語に対応したグローバル版の正式サービス開始!

スマートフォン・PC向けシネマティック錬金術RPG『レスレリアーナのアトリエ〜忘れられた錬金術と極夜の解放者〜』、英語・繁体字中国語・簡体字中国語に対応したグローバル版の正式サービス開始!

-

ソニーグループ並びにコーエーテクモホールディングスとの資本業務提携 及び第三者割当による自己株式の処分に関するお知らせ

ソニーグループ並びにコーエーテクモホールディングスとの資本業務提携 及び第三者割当による自己株式の処分に関するお知らせ

-

アカツキグループ、ドコモ、メディアドゥ、MyAnimeListによる 海外向け電子コミック配信サービス提供に向けた業務提携契約の締結について

~日本のマンガ作品を新たに海外に向け配信する事業を展開~

アカツキグループ、ドコモ、メディアドゥ、MyAnimeListによる 海外向け電子コミック配信サービス提供に向けた業務提携契約の締結について

~日本のマンガ作品を新たに海外に向け配信する事業を展開~

-

スマートフォン向けシネマティック錬金術RPG、『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』正式サービス開始!

スマートフォン向けシネマティック錬金術RPG、『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』正式サービス開始!

-

アカツキゲームスの”いま”をお届けするオンライン発表会『Akatsuki Games Now』、2023年8月18日午後7時に配信決定!

アカツキゲームスの”いま”をお届けするオンライン発表会『Akatsuki Games Now』、2023年8月18日午後7時に配信決定!

-

スマートフォン向けシネマティック錬金術RPG『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』、株式会社コーエーテクモゲームスとの共同開発に関するお知らせ

スマートフォン向けシネマティック錬金術RPG『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』、株式会社コーエーテクモゲームスとの共同開発に関するお知らせ

-

アカツキゲームス、コーポレートロゴ変更のお知らせ

アカツキゲームス、コーポレートロゴ変更のお知らせ

-

アカツキゲームスのIP創出プロジェクト『魔女のふろーらいふ』、NetEase Games開発・配信によるゲーム化が決定!

アカツキゲームスのIP創出プロジェクト『魔女のふろーらいふ』、NetEase Games開発・配信によるゲーム化が決定!

-

株式会社コーエーテクモゲームスと株式会社アカツキゲームス、新作ゲームタイトル共同開発に関するお知らせ

株式会社コーエーテクモゲームスと株式会社アカツキゲームス、新作ゲームタイトル共同開発に関するお知らせ

-

『Behind the Frame 〜とっておきの景色を〜』の「Silver Lining Studio」制作の新作謎解きゲームがSteamに公開!「撮影」で愛を探す冒険が始まる!

『Behind the Frame 〜とっておきの景色を〜』の「Silver Lining Studio」制作の新作謎解きゲームがSteamに公開!「撮影」で愛を探す冒険が始まる!

-

アカツキゲームス公式サイトリニューアルオープンのお知らせ

アカツキゲームス公式サイトリニューアルオープンのお知らせ

-

アカツキゲームス、プロeスポーツチーム『PULVEREX』を新設 「Apex Legends」部門が世界大会 ALGS Championshipに出場

アカツキゲームス、プロeスポーツチーム『PULVEREX』を新設 「Apex Legends」部門が世界大会 ALGS Championshipに出場

-

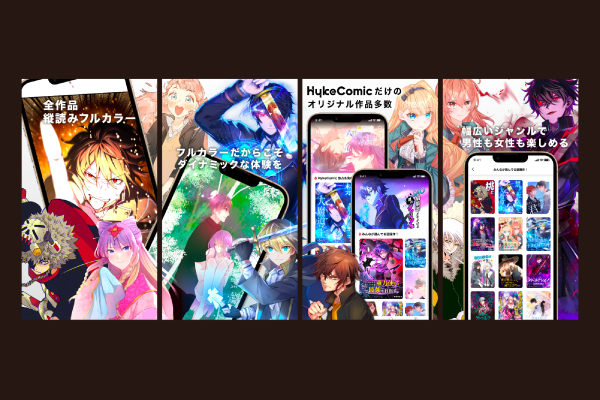

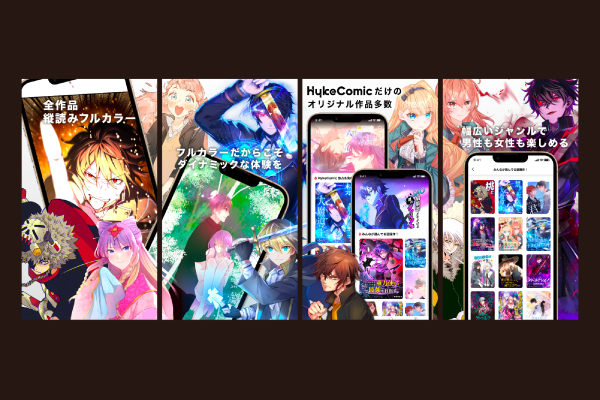

縦読みフルカラーコミックアプリ「HykeComic」 正式サービス開始のお知らせ 国内初リリース作品25タイトルを含む100作品強を掲載

縦読みフルカラーコミックアプリ「HykeComic」 正式サービス開始のお知らせ 国内初リリース作品25タイトルを含む100作品強を掲載

-

縦読みフルカラーコミックアプリ「HykeComic」、 2022年6月下旬の国内正式リリース決定のお知らせ

縦読みフルカラーコミックアプリ「HykeComic」、 2022年6月下旬の国内正式リリース決定のお知らせ

-

アカツキ、25億円規模のWeb3特化ファンド「Emoote」を設立 STEPNなど20以上にトークン投資実績

アカツキ、25億円規模のWeb3特化ファンド「Emoote」を設立 STEPNなど20以上にトークン投資実績

-

取締役候補者を含む新経営体制のお知らせ

取締役候補者を含む新経営体制のお知らせ

-

株式会社アカツキゲームス営業開始について

株式会社アカツキゲームス営業開始について

-

アカツキ、50億円規模の新ファンド「Dawn Capital」を組成

アカツキ、50億円規模の新ファンド「Dawn Capital」を組成

-

『TRIBE NINE(トライブナイン)』テレビアニメが2022年1月から放送&配信決定!さらに、スマートフォン3DアクションRPG化が決定!

併せて公式サイトが本オープン!本作の世界観やキャラクター情報、最新PVを公開!

『TRIBE NINE(トライブナイン)』テレビアニメが2022年1月から放送&配信決定!さらに、スマートフォン3DアクションRPG化が決定!

併せて公式サイトが本オープン!本作の世界観やキャラクター情報、最新PVを公開!

スマートフォン・PC向けシネマティック錬金術RPG『レスレリアーナのアトリエ〜忘れられた錬金術と極夜の解放者〜』、英語・繁体字中国語・簡体字中国語に対応したグローバル版の正式サービス開始!

スマートフォン・PC向けシネマティック錬金術RPG『レスレリアーナのアトリエ〜忘れられた錬金術と極夜の解放者〜』、英語・繁体字中国語・簡体字中国語に対応したグローバル版の正式サービス開始!

スマートフォン向けシネマティック錬金術RPG、『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』正式サービス開始!

スマートフォン向けシネマティック錬金術RPG、『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』正式サービス開始!

アカツキゲームスの”いま”をお届けするオンライン発表会『Akatsuki Games Now』、2023年8月18日午後7時に配信決定!

アカツキゲームスの”いま”をお届けするオンライン発表会『Akatsuki Games Now』、2023年8月18日午後7時に配信決定!

スマートフォン向けシネマティック錬金術RPG『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』、株式会社コーエーテクモゲームスとの共同開発に関するお知らせ

スマートフォン向けシネマティック錬金術RPG『レスレリアーナのアトリエ ~忘れられた錬金術と極夜の解放者~』、株式会社コーエーテクモゲームスとの共同開発に関するお知らせ

アカツキゲームス、コーポレートロゴ変更のお知らせ

アカツキゲームス、コーポレートロゴ変更のお知らせ

アカツキゲームスのIP創出プロジェクト『魔女のふろーらいふ』、NetEase Games開発・配信によるゲーム化が決定!

アカツキゲームスのIP創出プロジェクト『魔女のふろーらいふ』、NetEase Games開発・配信によるゲーム化が決定!

株式会社コーエーテクモゲームスと株式会社アカツキゲームス、新作ゲームタイトル共同開発に関するお知らせ

株式会社コーエーテクモゲームスと株式会社アカツキゲームス、新作ゲームタイトル共同開発に関するお知らせ

『Behind the Frame 〜とっておきの景色を〜』の「Silver Lining Studio」制作の新作謎解きゲームがSteamに公開!「撮影」で愛を探す冒険が始まる!

『Behind the Frame 〜とっておきの景色を〜』の「Silver Lining Studio」制作の新作謎解きゲームがSteamに公開!「撮影」で愛を探す冒険が始まる!

アカツキゲームス公式サイトリニューアルオープンのお知らせ

アカツキゲームス公式サイトリニューアルオープンのお知らせ

アカツキゲームス、プロeスポーツチーム『PULVEREX』を新設 「Apex Legends」部門が世界大会 ALGS Championshipに出場

アカツキゲームス、プロeスポーツチーム『PULVEREX』を新設 「Apex Legends」部門が世界大会 ALGS Championshipに出場

縦読みフルカラーコミックアプリ「HykeComic」 正式サービス開始のお知らせ 国内初リリース作品25タイトルを含む100作品強を掲載

縦読みフルカラーコミックアプリ「HykeComic」 正式サービス開始のお知らせ 国内初リリース作品25タイトルを含む100作品強を掲載

縦読みフルカラーコミックアプリ「HykeComic」、 2022年6月下旬の国内正式リリース決定のお知らせ

縦読みフルカラーコミックアプリ「HykeComic」、 2022年6月下旬の国内正式リリース決定のお知らせ

株式会社アカツキゲームス営業開始について

株式会社アカツキゲームス営業開始について